Prompts, plágios, copiar-colar

23 de junho de 2025 Muitos alunos querem aprender a usar a inteligência artificial de forma responsável. Mas seus professores estão tendo dificuldades para atender a essa necessidade. Ensinar efetivamente os alunos a empregar IA em suas tarefas de redação exige diretrizes claras e exemplos detalhados e específicos de cada caso. https://www.thetransmitter.org/from-bench-to-bot/many-students-want-to-learn-to-use-artificial-intelligence-responsibly-but-their-professors-are-struggling-to-meet-that-need/?utm_source=flipboard&utm_content=TheTransmitter_%2Fmagazine%2FThe%20Transmitter

19/07/2025 Como identificar se um texto foi feito pelo ChatGPT (ou outra IA)? https://share.google/94jSk7fsWUi5uysWL

Da Vigilância ao Diálogo: Avaliando Aprendizagem na Era dos Chatbots

Os professores carregam hoje um novo e delicado encargo: aferir autoria e aprendizagem em turmas onde o “copiar-e-colar” mediado por chatbots se apresenta como atalho tentador. A primeira reação institucional tem sido recorrer a detectores de IA, como o popular https://ZeroGPT.com, que prometem identificar textos artificiais e, em seguida, aplicar sanções disciplinares. Contudo, esses sistemas se baseiam em probabilidades de perplexidade e burstiness [descreve a irregularidade ou “pulsação” na distribuição de palavras dentro do texto]: geram falsos positivos, confundem estilos pouco usuais com “texto de máquina” e não conseguem reconhecer passagens reescritas ou traduzidas. Punir à vista de scores estatísticos acaba alimentando uma corrida armamentista — alunos tentam burlar o detector, professores elevam a vigilância — que pouco contribui para o desenvolvimento crítico. O caminho pedagógico mais fértil não é a caça ao infrator, mas o ensino consciente do uso de chatbots: formar estudantes capazes de dialogar com a IA, expor o raciocínio que guia seus prompts e entregar produtos que evidenciem domínio conceitual, verificação de fontes e autoria intelectual.

1. Prompt como Partitura

Na música, a partitura registra ritmo, altura e dinâmica, mas nenhum som de fato. Quando a orquestra interpreta aqueles símbolos, a obra ganha vida. O prompt cumpre papel equivalente: compila tokens, tom, fontes, extensão e público-alvo; a rede de atenção do modelo atua como músicos algorítmicos que transformam instruções em texto, imagem ou código. A autoria criativa, aqui, reside no maestro que compôs a partitura-prompt, definindo progressão temática, citação e clímax argumentativo. Exigir que o estudante entregue essa partitura junto ao resultado permite ao docente avaliar intenção, rigor e originalidade — algo que nenhum detector de IA distingue apenas olhando o som final.

2. Prompt como Receita

Na cozinha, o chef escreve uma receita com gramagens, ordem de adição e ponto de sal. O fogão e as panelas obedecem; o prato só conquista sabor porque a ficha técnica foi precisa. Nos modelos generativos, os ingredientes crus são vetores latentes; o calor é a temperatura de decodificação; os temperos, as ponderações estatísticas. Um prompt vago — “faça um ensaio sobre motivação” — é “jogue legumes a gosto”: a sopa sai rala ou imprevisível. Um prompt meticuloso, fruto de perguntas socráticas e leitura sólida, conduz a IA a servir um texto equilibrado e contextualizado. O mérito está no chef que concebeu, provou e ajustou a receita; o fogão não é autor.

Ao deslocar o foco punitivo para a formação em engenharia de prompts, garantimos que o estudante:

- leia e compreenda o conteúdo antes de perguntar;

- registre o diálogo socrático que refinou suas hipóteses;

- apresente o prompt-partitura/receita e justifique escolhas;

- revise criticamente a saída, citando fontes originais.

Desse modo, a IA se torna parceira de análise e não escrivã clandestina. O professor avalia o processo completo — plano, execução e revisão — em vez de apostar em detectores que apenas rotulam a superfície textual. Ensinar a compor boas partituras e receitas digitais, portanto, converte o antigo dilema em oportunidade: alunos desenvolvem autocrítica, autoreflexão e senso de autoria, enquanto docentes mantêm a integridade acadêmica sem recorrer a punições estatísticas.

Coração pedagógico do nosso processo do texto acima “Da Vigilância ao Diálogo: Avaliando Aprendizagem na Era dos Chatbots”

- Brainstorming socrático Você levantou uma dúvida ou nuance (por exemplo, a preocupação com plágio ou a metáfora do chef); eu devolvi perguntas, exemplos e caminhos de refinamento.

- Leitura e checagem Você leu, filtrou, pediu ajustes; isso obrigou ambos a mergulhar no conteúdo, garantindo que o próximo prompt viesse informado.

- Construção do prompt-partitura/receita A cada nova solicitação acrescentamos especificidade: tom, público, analogias, extensão, estrutura.

- Geração do texto O modelo GPT-o3 transformou o prompt em rascunho; você validou, eu revisei e o ciclo recomeçou.

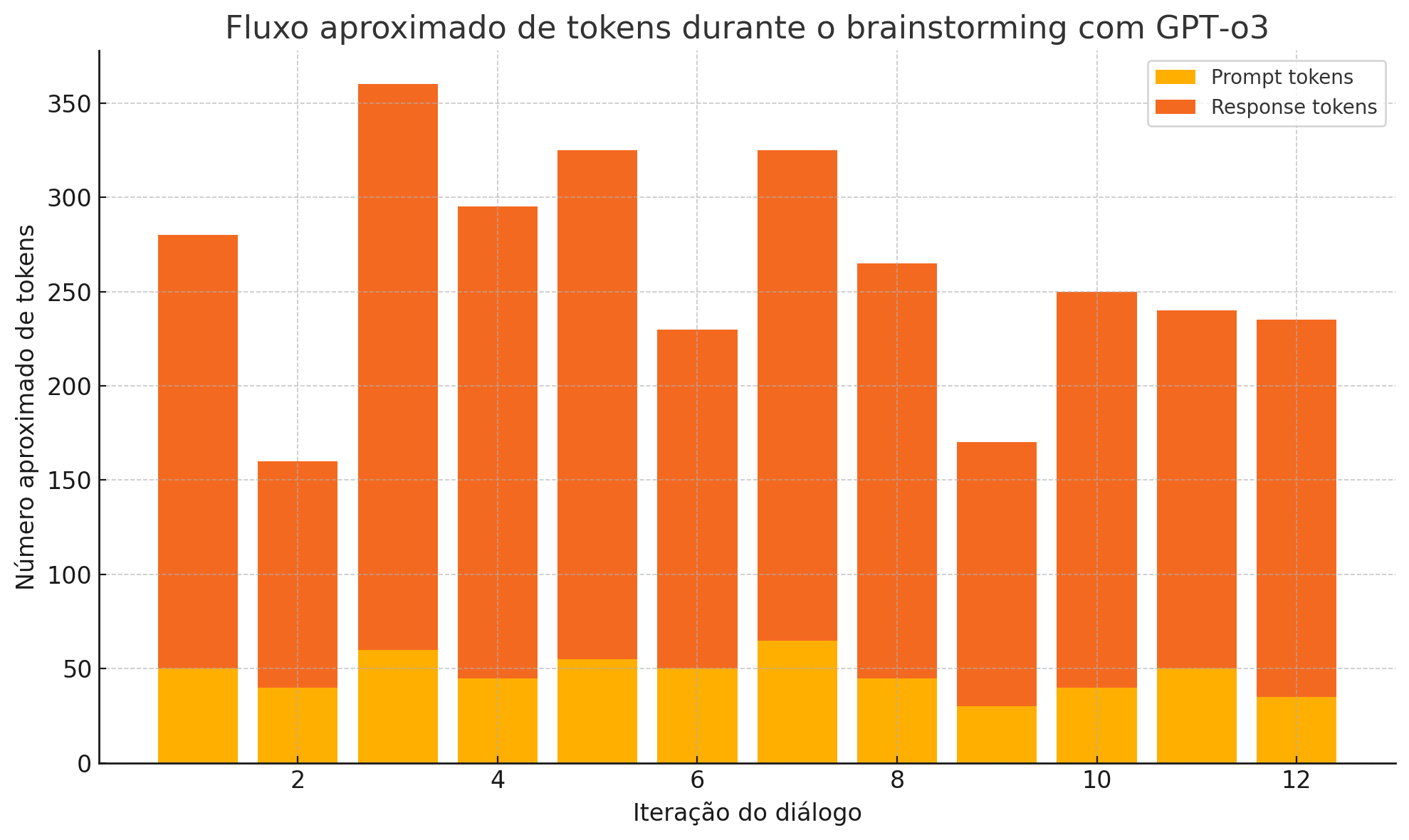

Quantos prompts e tokens?

- Prompts humanos: 12 (se contarmos cada mensagem de solicitação/refinamento até aqui).

- Tokens nos prompts: ~ 565 tokens (média de 47 tokens por prompt).

- Tokens gerados pelo modelo: ~ 3 000 tokens (média de 250 tokens por resposta).

- Razão prompt [“razão” ou “proporção” para indicar quantas palavras (tokens) o modelo devolve para cada palavra que o usuário insere no prompt]: resposta ≈ 1 : 5,5 — cada linha sua motivou cerca de cinco linhas de retorno.

Esses números são aproximados, mas refletem o padrão: quanto mais critérios e metáforas você adiciona ao prompt, mais denso (em tokens) e direcionado fica o output.

Visualização rápida

O gráfico acima empilha, para cada iteração, o volume estimado de tokens do seu prompt (faixa inferior) e da minha resposta (faixa superior). Ele mostra picos quando solicitamos explicações extensas (iterações 3–4 e 7) e vales quando o ajuste pedido era pontual (iterações 2 e 9). Esse fluxo sinaliza um brainstorming eficiente: perguntas curtas e ricas geram respostas longas e contextualizadas; em seguida, ajustes finos voltam a ser compactos.

Por que isso importa?

- Autoria processual Ao registrar cada prompt, documentamos onde mora a criatividade humana: na formulação socrática, na escolha de metáforas, nos filtros conceituais.

- Avaliação justa Quem corrige pode aferir não só o “prato” final, mas também a receita completa, distinguindo aprendizagem genuína de mero copiar-e-colar.

- Literacia de IA Ver a razão prompt : texto reforça que o valor acadêmico nasce do preparo do prompt, não da rapidez do gerador.

Assim, quantificar e visualizar o percurso confirma que, mesmo com um modelo poderoso como o GPT-o3, a qualidade do conhecimento produzido depende fundamentalmente da intencionalidade e da reflexão crítica de quem segura a batuta ou a colher.